GPT–4o mini zostało ogłoszone wczoraj i można mówić o niespodziance od OpenAI. Bez większych zapowiedzi zadebiutowała nowa wersja modelu AI. Czym się charakteryzuje kolejna odsłona najpopularniejszego chatbota?

GPT-4 Mini – w przeciwieństwie do GPT-3.5, GPT 4o, GPT-4 i DALL·E – jest przeznaczony tylko dla programistów. Ma być tańszy od płatnych wersji, przystępniejszy i bardziej zaawansowany niż GPT-3.5, który już niebawem ma zostać całkowicie wycofany.

GPT–4o mini nagle pojawia się jako tańsza i przystępniejsza opcja dla programistów

Od wczoraj (tj. od 18 czerwca 2024 roku) użytkownicy ChatGPT w programach Free, Plus i Team mogą korzystać z GPT-4o Mini zamiast GPT-3.5 Turbo, a użytkownicy Enterprise będą mieli dostęp w przyszłym tygodniu. GPT-3.5 niebawem zniknie dla zwykłych użytkowników, ale nadal będzie dostępny dla programistów za pośrednictwem interfejsu API, jeśli nie zechcą się przełączać się na GPT-4o Mini. To znaczący krok OpenAI w budowaniu mniejszych modeli AI i odpowiedź na produkty konkurencji, takie jak Llama 3 8b, Claude Haiku, czy Gemini 1.5 Flash.

Myślę, że GPT-4o Mini naprawdę bierze udział w misji OpenAI polegającej na zwiększeniu dostępności AI dla ludzi. Jeśli chcemy, aby sztuczna inteligencja przyniosła korzyści w każdym zakątku świata, w każdej branży, w każdej aplikacji, musimy uczynić sztuczną inteligencję znacznie bardziej przystępną cenowo

Olivier Godement w krótkim wywiadzie dla The Verge

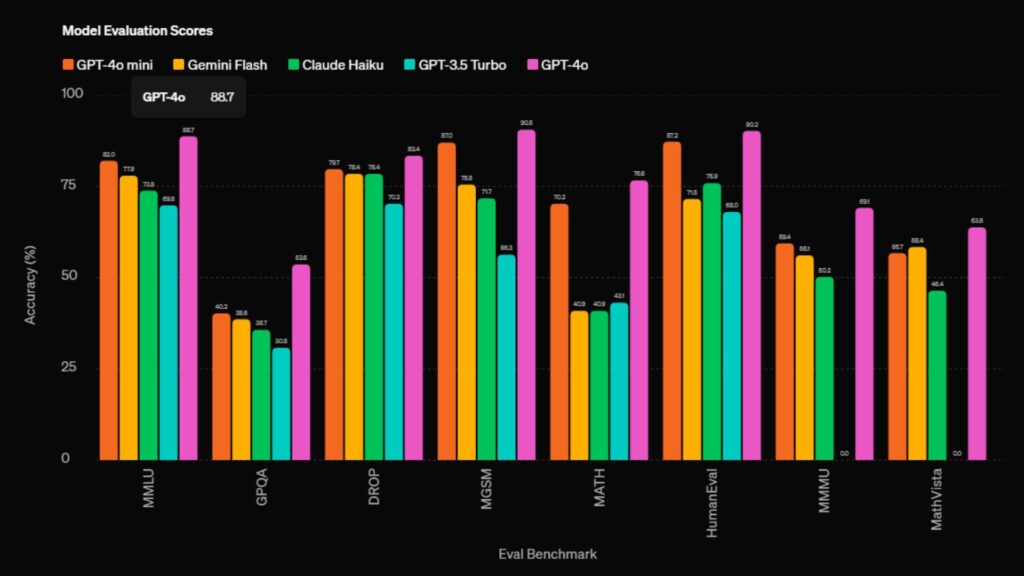

GPT-4 Mini wypada lepiej niż inne, proste modele AI dostępne na rynku

GPT-4 Mini ma być nawet 60% tańszy niż GPT-3.5 Turbo oraz GPT 4o. OpenAI mówi o kosztach rzędu 15 centów za milion tokenów wejściowych i 60 centów za milion tokenów wyjściowych. Na razie model ma obsługiwać tekst i wizję, ale programiści planują również wprowadzić wideo, audio i pliki graficzne. Data graniczna wiedzy modelu to październik 2023 roku.

To ogromne ułatwienie dla deweloperów, którzy chcą w prosty i tani sposób tworzyć narzędzia AI poprzez interfejs API. OpenAI twierdzi, że GPT-4 Mini osiąga lepsze wyniki na tle innych, prostych modeli AI, dostępnych na rynku.

Nie są to puste słowa, bowiem model AI został przetestowany na arenie chatbot LMSYS.org. Uzyskał 82% MMLU. Jest to pomiar masywnego zrozumienia języka wielozadaniowego. Składa się z około 16 000 pytań wielokrotnego wyboru obejmujących 57 przedmiotów akademickich, w tym matematykę, filozofię, prawo i medycynę. Dla porównania – Claude 3 Haiku uzyskał 75,2%, a Gemini 1.5 –78,9 %.

[…] Flash 1.5 to w zasadzie odpowiedź Google na ChatGPT-4o od OpenAI. Kiedy zadebiutował, to nowy model jednak wypadł gorzej w benchmarkach, ale może się […]