O etyce w kontekście korzystania z AI dużo się już mówi. Raz, że narzędzia te obarczone są błędami, uprzedzeniami i stereotypami. Po drugie – wiemy, że AI korzysta z pracy całej masy ludzi oraz materiałów, które powinny być objęte prawami autorskimi, z szerokiego spectrum dziedzin takich jak: literatura, sztuka, kinematografia, badania i nauka. Czy aby na pewno tego typu treści powinny być dowolnie wykorzystywane?

Coraz mocniejsze protesty artystów, np. ubiegłoroczny strajk w Hollywood albo petycja muzyków, określająca AI jako „atak na ludzką kreatywność”, dowodzą tego, że konieczne jest wzmocnienie praw autorskich twórców. Ba – AI jest trenowane na różnych informacjach i mogą to być nawet nasze dane z rozmów, e-maili, itp. – a my nawet o tym nie wiemy… Nie mamy na to większego wpływu, ale jesteśmy odpowiedzialni za to, jak korzystamy ze sztucznej inteligencji. Zatem: jak korzystać z narzędzi AI tak, by było to etyczne? A może po prostu krytyczne – łamane – przez mądre?

O etyce korzystania z AI słów kilka

Tuż po moim tekście, dotyczącym czytania w cyfrowej erze, w którym wspominałam m.in. o generowaniu recenzji książkowych przez AI, przez bookmedia przetoczyła się kolejna afera. Wyszło na jaw, że jedna z booktokerek publikowała recenzje książek stworzone właśnie przez AI, tłumacząc to tym, iż wzięła na siebie zbyt dużo tzw. współprac wydawniczych i nie zdążyła wszystkiego zrecenzować samodzielnie.

Sam fakt, że coś takiego się zdarzyło w ogóle mnie nie zdziwił – wręcz przeciwnie, było to dla mnie oczywiste, że skoro są takie możliwości, ludzie będą z nich korzystać. Bardziej zastanowiło mnie jak te „recenzje” wyglądały. Co może powiedzieć ChatGPT na temat książek przedpremierowych – bo przecież współpraca z wydawnictwami obejmuje przede wszystkim takie pozycje?

Przykład recenzji książki napisanej przez ChatGPT

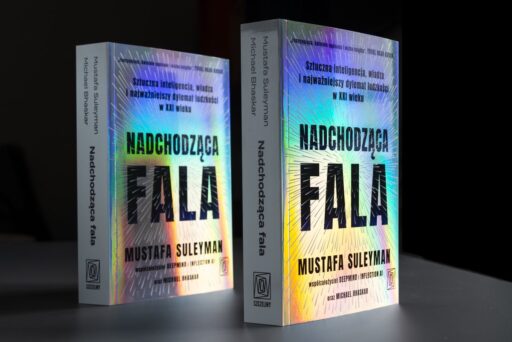

Typową opinię, wygenerowaną przez AI, co możemy rozpoznać po dość ogólnych sformułowaniach, trudnym słownictwie oraz powoływaniu się na czyjeś opinie. Weźmy tekst stworzony przez Copilota. Całkiem nieźle poradził on sobie z recenzją „Nadchodzącej fali” Mustafy Sulejmana – dopiero co wydanym w Polsce reportażu o AI, który został w bookmediach przyjęty z mieszanymi uczuciami:

“Nadchodząca fala” Mustafy Sulejmana to książka, która zanurza czytelnika w głębokie wody sztucznej inteligencji (AI) i jej wpływu na współczesny świat. Autor, będący współzałożycielem firmy DeepMind, dzieli się swoimi przemyśleniami i doświadczeniami, stając się przewodnikiem po zawiłych meandrach AI. (…)

Autor nie unika trudnych tematów. Porusza kwestię dualności AI, która może być zarówno nadzieją na lepszą przyszłość, jak i narzędziem służącym do manipulacji i kontroli. Sulejman ostrzega przed tsunami technologicznym, które może przynieść nie tylko postęp, ale i chaos.

Recenzje książki są mieszane, ale większość czytelników docenia głębię analizy i przystępność przekazu. Średnia ocen na portalu LubimyCzytać.pl wynosi 6,9/10, co świadczy o tym, że książka znajduje swoich zwolenników.

Podsumowując, “Nadchodząca fala” to lektura obowiązkowa dla każdego, kto interesuje się przyszłością technologii i jej wpływem na społeczeństwo. To książka, która skłania do refleksji i dyskusji o kierunku, w którym zmierza nasz świat.

Widać, że opinia stworzona przez AI jest bardzo neutralna w swoim tonie. Raczej nie znajdziemy tu dogłębnej analizy, trudno też o krytykę. Rzecz jasna można podrążyć, pobawić się, poprosić o bardziej zniuansowane opinie, ale to zawsze będą czyjeś teksty, które już są w sieci, np. krytycy mogą zarzucić, że “Nadchodząca fala” nie oferuje konkretnych rozwiązań ani praktycznych wskazówek, jak można by zarządzać i kierować rozwojem AI w sposób korzystny dla społeczeństwa.

Miło, że Copilot podaje linki, skąd zaczerpnął dane zdanie. To jednak skutkuje tym, że bazując na czyichś błędach albo poglądach, AI może zawrzeć w recenzji nieprawidłowe interpretacje, przekręcone treści, a nawet kłamstwa. By nie wspomnieć o słynnych halucynacjach. By to zweryfikować – trzeba faktycznie wiedzieć, o czym jest dana pozycja i co chcemy osiągnąć, pisząc opinię o niej, czyli wypadałoby mieć własne zdanie.

Co może pójść nie tak? Bardzo wiele!

A o to trudno, jeśli się książki nie czytało… Sama kiedyś testowałam tworzenie recenzji z pomocą AI – poprosiłam mianowicie o wygenerowanie recenzji „Empuzjona”. Najpierw ChatGPT wyprodukował coś o zmyślonej książce (halucynacje). Kiedy odpowiedziałam mu, że „to nie ta książka”, przyznał, że pozycja, o której napisał jest wymyślona i wygenerował kolejny tekst – o książce prawdziwej, ale nie mającej nic wspólnego z „Empuzjonem”. Na moją podpowiedź, że chodzi o powieść Olgi Tokarczuk, okazało się, że AI owszem, Tokarczuk kojarzy (noblistka!), ale „Empuzjona” nie zna i polecił mi… udać się do biblioteki. A przecież „Empuzjon” nie był kompletną nowością – miało to miejsce w lutym tego roku, a został wydany w roku 2022, więc w sieci są informacje na jego temat, które powinny były zasilić bazę ChatGPT…

Abstrahując już od tego jak wygenerować sensowną recenzję w ChatGPT lub innym narzędziu AI, można się zastanowić nad celowością tego typu działań. Kogo zachęci taka recenzja? Nawet jeśli jest to młodzieżówka…a może zwłaszcza jeśli są to młodzieżówki, gdyż młodzi ludzie raczej nie reagują dobrze na podręcznikowe teksty, pozbawione emocji. Poza tym – jest chyba dla wszystkich oczywiste, że jeśli zamieszczając takie materiały nie informujemy, że są one dziełem AI. To jest to po prostu oszustwo (a zamieszczona opinia nie jest opinią „własną”, autorską, ale zlepkiem opinii innych osób) – i rzecz jasna to było powodem takiego oburzenia internautów. A co na to wydawnictwo?

Czy wydawnictwa będą korzystać z ChatGPT?

Gdyby wydawnictwo chciało opinii z AI, to stworzyłoby je sobie samo, nie zawracając sobie głowy współpracami z blogerami – i jeśli większa liczba influencerów książkowych zacznie uprawiać tego typu sztuczki – to być może wydawnictwa faktycznie dojdą do wniosku, że „szkoda czasu i atłasu”. Moim zdaniem pokazuje to też słabość tej formy promocji i branży wydawniczej, która na takiej promocji bazuje. Wydawnictwa powinny się naprawdę dobrze zastanowić, komu przekazują książki do recenzji i jakie są kryteria tych współprac.

Tak naprawdę jednak ręce mi opadły, kiedy obejrzałam filmik owej tiktokerki, w którym dość nieporadnie tłumaczyła się z tego, co zaszło… Szło to mniej więcej tak: „stworzyłam teksty z … jakiegoś aj…..al?”. 19-latka nawet nie wiedziała z czego w zasadzie korzysta i co to jest to „ai” albo „al” – po prostu jest narzędzie, to wrzuciła i tyle. Przyznam, że nie przyszło mi do głowy, że w 2024 roku, kiedy AI wyskakuje z lodówki, można nic nie wiedzieć na ten temat. Nic dziwnego, że nie przyszły jej do głowy takie wątpliwości, jak mnie powyżej – bo de facto – nawet nie wiedziała, co robi. I to właśnie jest sedno problemu. Bo pokazuje, że będzie cała masa ludzi, którzy będą korzystać z AI zupełnie bezrefleksyjnie. Bez zrozumienia na jakiej zasadzie działają te narzędzia, a co dopiero jakie konsekwencje może mieć korzystanie z nich. I to nie ze złej woli, ale po prostu z ignorancji – a ta zawsze będzie obecna – obojętnie ile by się mówiło i pisało na dany temat.

Czy sztuczna inteligencja nauczy się empatii, czyli Blade Runner to już nie tylko Sci-fi?

Inny przykład na niezrozumienie działania AI (dość klasyczny) też zaczerpnęłam z mediów społecznościowych. Natknęłam się mianowicie na post o tym, że studenci psychologii dostali za zadanie wypróbować ChatGPT (wersję 3.5, darmową, a więc bardzo niedoskonałą) do przeprowadzenia konsultacji psychologicznych. I pytanie: czy myślicie, że z ChatGPT będzie można kiedyś wykorzystywać w psychoterapii i czy nauczy się on empatii?.

Olaboga, pomyślałam sobie – i nie tylko ja. To jest bardzo źle postawione pytanie, świadczące o niezrozumieniu działania ChatGPT – padła od razu bardzo mądra odpowiedź. Po pierwsze niezrozumienie, że chatbot to maszyna, która generuje jakieś zrandomizowane i zestandaryzowane odpowiedzi i nie nadaje się do tak wrażliwych zadań, jak psychoterapia. Wystarczy źle postawione pytanie i prompt wiodący na manowce. Katastrofa gotowa.

Zresztą: przecież zawody wymagające nawiązywania relacji z drugim człowiekiem miały być „bezpieczne” przez AI, a tu się okazuje, że już ludzie kombinują, jak by tu wyrugować człowieka i z tej dziedziny… Po drugie: ChatGPT to maszyna – jak możemy oczekiwać empatii od maszyny? Nawet jeśli jej odpowiedzi będą się nam wydawać empatyczne, to dlatego, że są one dziełem algorytmu, a nie dlatego, że „nauczył się” on empatii i tę empatię odczuwa.

Kolejna rzecz to niebezpieczeństwa polegające na wchodzeniu w „relacje” z maszyną (a taką relacją jest też relacja pacjent – terapeuta), o czym pisałam TUTAJ. I o coś takiego pytają studenci psychologii. Tego typu pytania świadczą więc o bardzo dużym niezrozumieniu w społeczeństwie, czym w ogóle jest AI, którą obecnie dysponujemy i niestety o tym, jak bardzo jesteśmy nieprzygotowani (przeciętni ludzie), do jej stosowania.

Problemem jest AI czy ludzie?

Możemy więc powtarzać do znudzenia, że póki co, to my jesteśmy pierwszą i ostatnią instancją weryfikującą materiały generowane przez AI, ale zawsze znajdą się tacy, którzy nie będą myśleć o jakiejś etyce, prawdzie, rzetelności – i to nawet niekoniecznie mając złe pobudki, tylko z niewiedzy.

Konkluzja jest taka sama, jak zawsze: problemem nie jest narzędzie, tylko ludzie nie wiedzący, jak się z nim obchodzić i nawet czasem nie wiedzący, że nie wiedzą 😉 Ludzi jest bardzo trudno kontrolować, więc jeśli nie wprowadzimy odgórnie regulacji i zabezpieczeń, to AI będzie na tyle „mądre”, lub etyczne, na ile pozwoli mu na to jego użytkownik. Może więc najwyższy czas zacząć edukować ludzi w kwestiach używania AI, a nie tylko podrzucać im kolejne wersje ChatGPT?

Materiał nie został wygenerowany przez AI. Napisała go dla was Gabi.

Zdjęcie wyróżniające wygenerowane przez ideogram.ai

[…] O etyce korzystania z AI. To co się dzieje na bookmediach to kosmos […]